Für einige Projekte brauchten wir eine einfache Möglichkeit, um Daten aus einer entfernten URL zu ziehen und zu speichern. Dazu brauchten wir noch die Möglichkeit, zu filtern und z.B. umgebendes HTML "auszuputzen".

Natürlich kann man dafür eine Extension schreiben, die ein eigenes Model mitbringt und die Daten selbst speichtert aber wenn man einfach nur ein paar Daten aus einem RSS-Feed oder einer anderen Website in einem tt_content-Element haben möchte, war das etwas zu viel Aufwand.

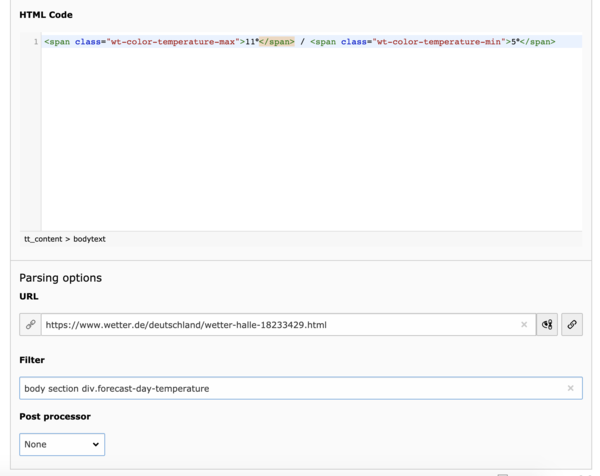

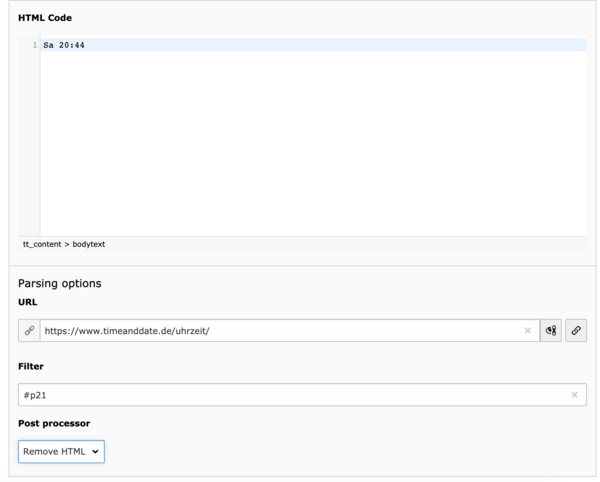

Dafür haben wir die bw_cache_uri entwickelt und die erledigt genau das.

Mit einem Postprocessor kann man bestimmte Teile der Remote-Daten selektieren oder HTML entfernen.